導言:智元發布首個通用具身基座模型——智元啟元大模型(Genie Operator-1),它開創性地提出了Vision-Language-Latent-Action (ViLLA) 架構,該架構由VLM(多模態大模型) + MoE(混合專家)組成,其中VLM借助海量互聯網圖文數據獲得通用場景感知和語言理解能力,MoE中的Latent Planner(隱式規劃器)借助大量跨本體和人類操作視頻數據獲得通用的動作理解能力,MoE中的Action Expert(動作專家)借助百萬真機數據獲得精細的動作執行能力,三者環環相扣,實現了可以利用人類視頻學習,完成小樣本快速泛化,降低了具身智能門檻,并成功部署到智元多款機器人本體,持續進化,將具身智能推上了一個新臺階。 |

2024年底,智元推出了 AgiBot World,包含超過100萬條軌跡、涵蓋217個任務、涉及五大場景的大規模高質量真機數據集。基于AgiBot World,智元今天正式發布智元通用具身基座大模型 Genie Operator-1(GO-1)。

GO-1:VLA進化到ViLLA

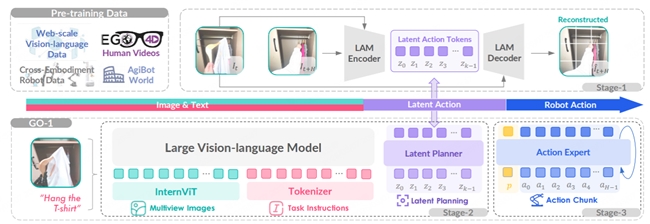

為了有效利用高質量的AgiBot World數據集以及互聯網大規模異構視頻數據,增強策略的泛化能力,智元提出了 Vision-Language-Latent-Action (ViLLA) 這一創新性架構。GO-1作為首個通用具身基座大模型,基于ViLLA構建。與 Vision-Language-Action (VLA) 架構相比,ViLLA 通過預測Latent Action Tokens(隱式動作標記),彌合圖像-文本輸入與機器人執行動作之間的鴻溝。在真實世界的靈巧操作和長時任務方面表現卓越,遠遠超過了已有的開源SOTA模型。

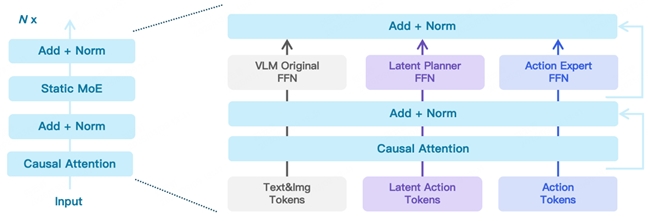

ViLLA架構是由VLM(多模態大模型) + MoE(混合專家)組成,其中VLM借助海量互聯網圖文數據獲得通用場景感知和語言理解能力,MoE中的Latent Planner(隱式規劃器)借助大量跨本體和人類操作數據獲得通用的動作理解能力,MoE中的Action Expert(動作專家)借助百萬真機數據獲得精細的動作執行能力。在推理時,VLM、Latent Planner和Action Expert三者協同工作:

VLM 采用InternVL-2B,接收多視角視覺圖片、力覺信號、語言輸入等多模態信息,進行通用的場景感知和指令理解

Latent Planner是MoE中的一組專家,基于VLM的中間層輸出預測Latent Action Tokens作為CoP(Chain of Planning,規劃鏈),進行通用的動作理解和規劃

Action Expert是MoE中的另外一組專家,基于VLM的中間層輸出以及Latent Action Tokens,生成最終的精細動作序列

下面展開介紹下MoE里2個關鍵的組成Latent Planner和Action Expert:

混合專家一:Latent Planner(隱式規劃器)

盡管AgiBot World 數據集已經是全球最大的機器人真機示教數據集,但這樣高質量帶動作標簽的真機數據量仍然有限,遠少于互聯網規模的數據集。為此,我們采用Latent Actions(隱式動作)來建模當前幀和歷史幀之間的隱式變化,然后通過Latent Planner預測這些Latent Actions,從而將異構數據源中真實世界的動作知識轉移到通用操作任務中。

? Latent Action Model(LAM,隱式動作模型)主要用于獲取當前幀和歷史幀之間Latent Actions的Groundtruth(真值),它由編碼器和解碼器組成。其中

? 編碼器采用Spatial-temporal Transformer,并使用Causal Temporal Masks(時序因果掩碼)。

? 解碼器采用Spatial Transformer,以初始幀和離散化的Latent Action Tokens作為輸入。

? Latent Action Tokens通過VQ-VAE的方式進行量化處理。

? Latent Planner負責預測這些離散的Latent Action Tokens,它與 VLM 主干網絡共享相同的 Transformer 結構,但使用了兩套獨立的FFN(前饋神經網絡)和Q/K/V/O(查詢、鍵、值、輸出)投影矩陣。Latent Planner這組專家會逐層結合 VLM 輸出的中間信息,通過Cross Entropy Loss(交叉熵損失)進行監督訓練

混合專家二:Action Expert(動作專家)

為了實現 High-frequency(高頻率)且 Dexterous(靈活)的操控,我們引入Action Expert,其采用Diffusion Model作為目標函數來建模低層級動作的連續分布。

? Action Expert結構設計上與Latent Planner類似,也是與 VLM 主干網絡共享相同的 Transformer 結構,但使用兩套獨立的FFN和Q/K/V/O投影矩陣,它通過Denoising Process(去噪過程)逐步回歸動作序列。

? Action Expert與VLM、Latent Planner分層結合,確保信息流的一致性與協同優化。

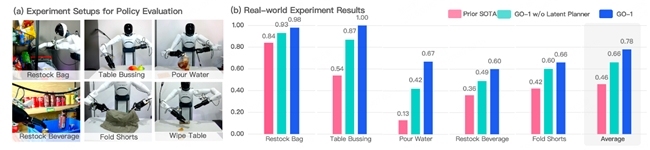

實驗效果

通過Vision-Language-Latent-Action (ViLLA) 創新性架構,我們在五種不同復雜度任務上測試 GO-1,相比已有的最優模型,GO-1成功率大幅領先,平均成功率提高了32%(46%->78%)。其中 “Pour Water”(倒水)、“Table Bussing”(清理桌面) 和 “Restock Beverage”(補充飲料) 任務表現尤為突出。此外我們還單獨驗證了ViLLA 架構中Latent Planner的作用,可以看到增加Latent Planner可以提升12%的成功率(66%->78%)。

GO-1:具身智能的全面創新

GO-1大模型借助人類和多種機器人數據,讓機器人獲得了革命性的學習能力,可泛化應用到各類的環境和物品中,快速適應新任務、學習新技能。同時,它還支持部署到不同的機器人本體,高效地完成落地,并在實際的使用中持續不斷地快速進化。

這一系列的特點可以歸納為4個方面:

? 人類視頻學習:GO-1大模型可以結合互聯網視頻和真實人類示范進行學習,增強模型對人類行為的理解,更好地為人類服務。

? 小樣本快速泛化:GO-1大模型具有強大的泛化能力,能夠在極少數據甚至零樣本下泛化到新場景、新任務,降低了具身模型的使用門檻,使得后訓練成本非常低。

? 一腦多形:GO-1大模型是通用機器人策略模型,能夠在不同機器人形態之間遷移,快速適配到不同本體,群體升智。

? 持續進化:GO-1大模型搭配智元一整套數據回流系統,可以從實際執行遇到的問題數據中持續進化學習,越用越聰明。

智元通用具身基座大模型GO-1的推出,標志著具身智能向通用化、開放化、智能化方向快速邁進:

? 從單一任務到多種任務:機器人能夠在不同場景中執行多種任務,而不需要針對每個新任務重新訓練。

? 從封閉環境到開放世界:機器人不再局限于實驗室,而是可以適應多變的真實世界環境。

? 從預設程序到指令泛化:機器人能夠理解自然語言指令,并根據語義進行組合推理,而不再局限于預設程序。

GO-1大模型將加速具身智能的普及,機器人將從依賴特定任務的工具,向著具備通用智能的自主體發展,在商業、工業、家庭等多領域發揮更大的作用,通向更加通用全能的智能未來。